-

VocalEdit_com

VocalEdit_com

- 13168

- 106

- 3

- 0

Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

PCM方式においては、ビット深度(16bitとか24bitとかいうアレ)が変わると、1サンプルごとにより細かい信号電圧が計測可能という説明がよくなされます。 実際そうなのですが、本当に「音の解像度」まで変わるのでしょうか?

2019-06-15 09:38:53 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

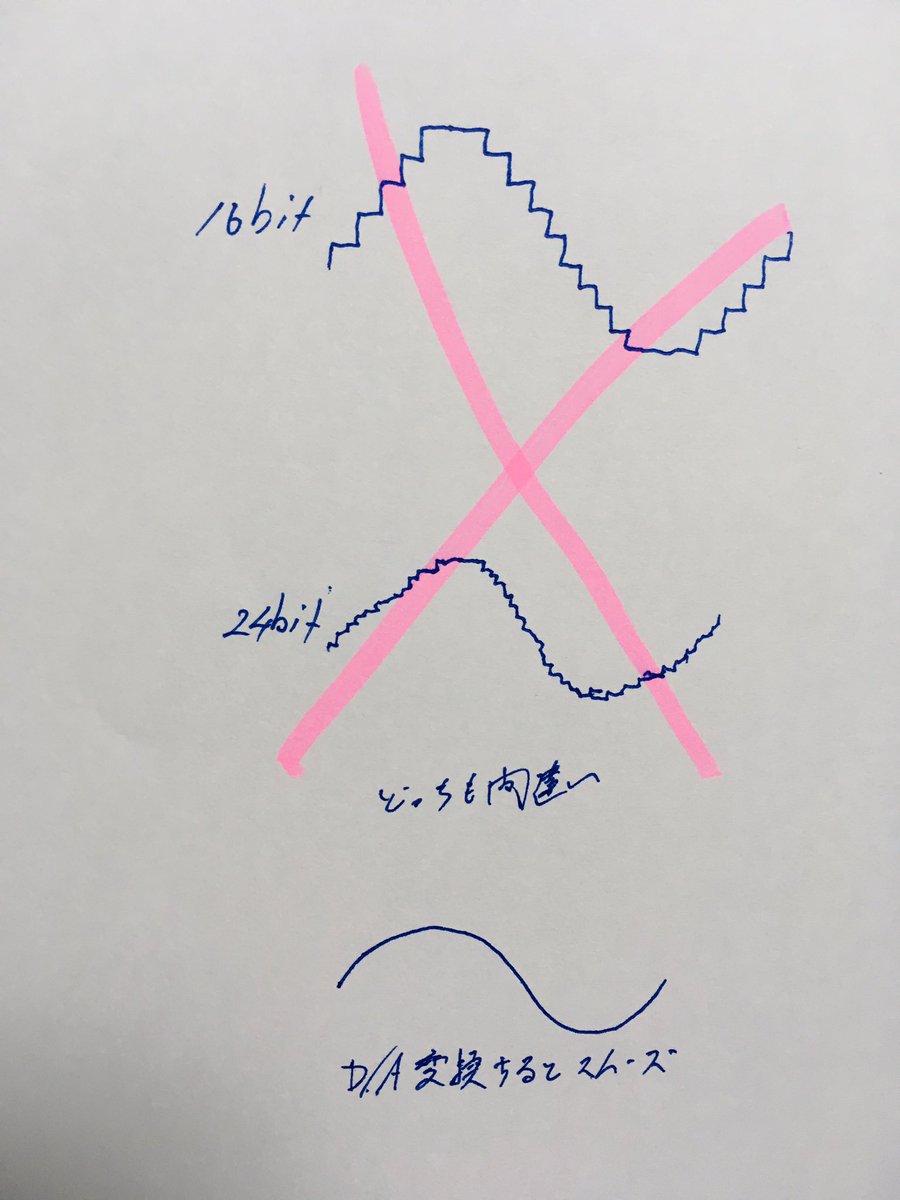

これもよく見かける図解で、ビット深度が増えることでサンプリングした信号波形がカクカクした線から比較的スムーズな線になっていたりします。しかし多くの場合、信号はD/A変換時にローパスフィルタを通過し、このようなカクカクはすべてスムーズな線として復元されます。

2019-06-15 09:39:23 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

実際に計測器で見ても、D/A変換されたサイン波において16bitの方が24bitよりカクカクしているようなことはありません。

2019-06-15 09:39:23 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

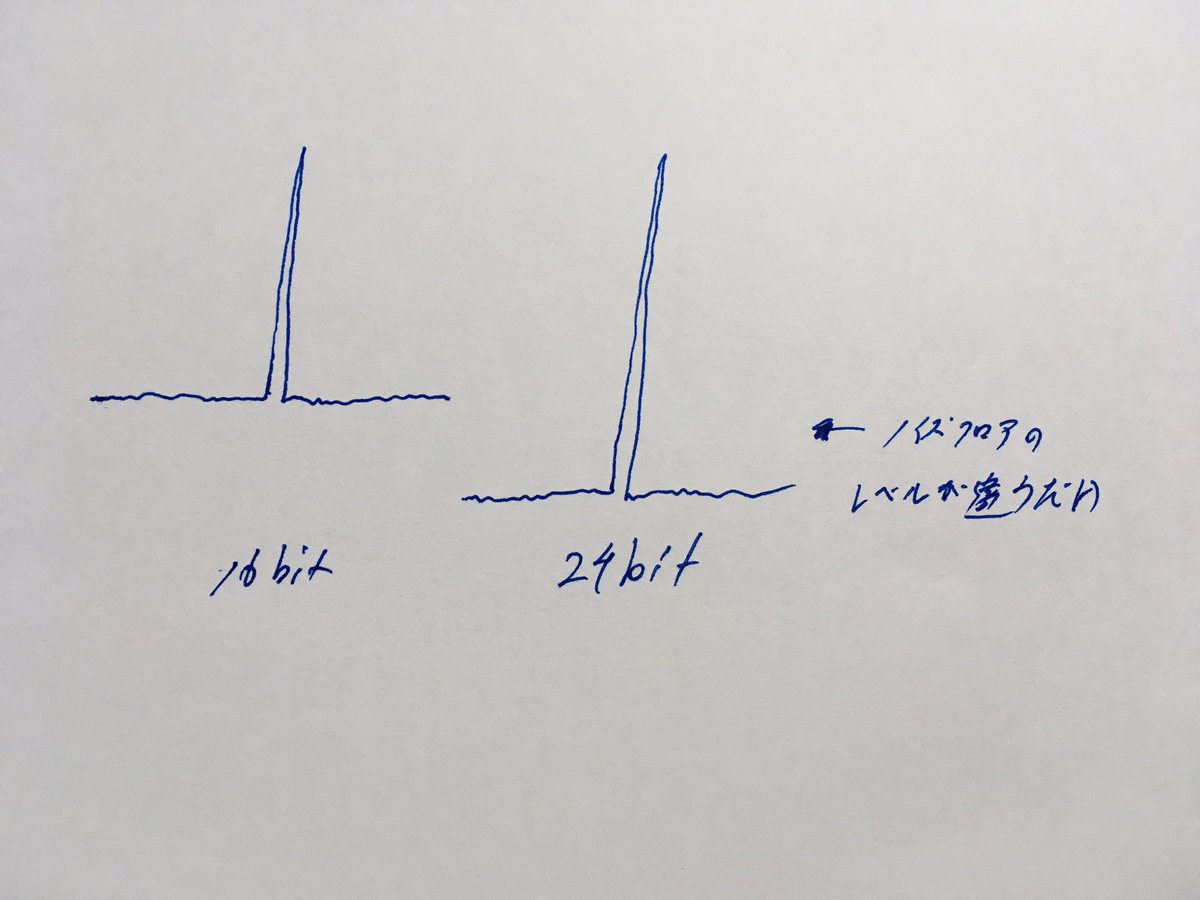

ではなにが変わるのかというと、ひとつ間違いなく変わるのはS/Nです。なぜかというと、ビット深度の差異や不足により、信号電圧値をもっとも近似するサンプルに丸め込まざるを得なかった場合、その誤差はホワイトノイズとなって現れます。

2019-06-15 09:40:03 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

なんとなくビット深度が高い方が解像度が高いイメージがありますが、なんてことはない、累積した誤差はすでにホワイトノイズとして現れており、ビット深度の差異による元信号に違いはありません。

2019-06-15 09:40:41 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

…という考え方を信じるかどうかは皆様のご判断に委ねますし筆者自身の考え方も保留とさせていただきたいのですが、このような一派は存在します。 なお、中間ファイルのビット深度は高いに越したことはありませんが、こと最終媒体に関しては20bitもあれば十分という主張する派閥はこの辺りに由来します

2019-06-15 09:41:03 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

つまり20bit x 6dB = 120dBのダイナミックレンジ(S/N)もあれば、 ・ヒトが知覚できる最大値~最小値をカバーできる ・そもそもS/Nが120bB以上あってもD/Aや周辺機器の熱雑音が勝る という考えです。

2019-06-15 09:41:30 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

この世界観においては、32bit D/A A/Dの利点は特にありません。実際に音がアナログスルーに近いと感じたのであれば、それは32bitであったからではなく、周辺回路も含めた機器の設計のせいかもしれません。 ※という考え方が存在するというお話です。以上。

2019-06-15 09:43:06 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

ビット深度が増えるとS/Nは向上します。むしろ変わるのはS/Nだけという考え方です(続く。上の話はのちほど再訪問します twitter.com/pukumaro/statu…

2019-06-15 13:46:01 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

ビット深度が増えると図の1段目から2段目のように目が細かくなる説明がよくなされます。これはある程度事実ですが、実際にはD/A変換時にローパスフィルタでスムーズになるので、どちらもカクカクした音を聞かされるわけではありません(続く pic.twitter.com/ZQIXnsEaAF

2019-06-15 13:48:02 拡大

拡大

Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

じゃぁどっちも完全な正弦波「だけ」を再現しているかというとそうでもなく、ビット深度不足、解像度不足により実際の電圧値と丸め込まれた近似値の間の誤差は累積してホワイトノイズになります。このノイズのレベル差がビット深度の唯一の違いです(続く pic.twitter.com/PQcDS130Ts

2019-06-15 13:50:51 拡大

拡大

Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

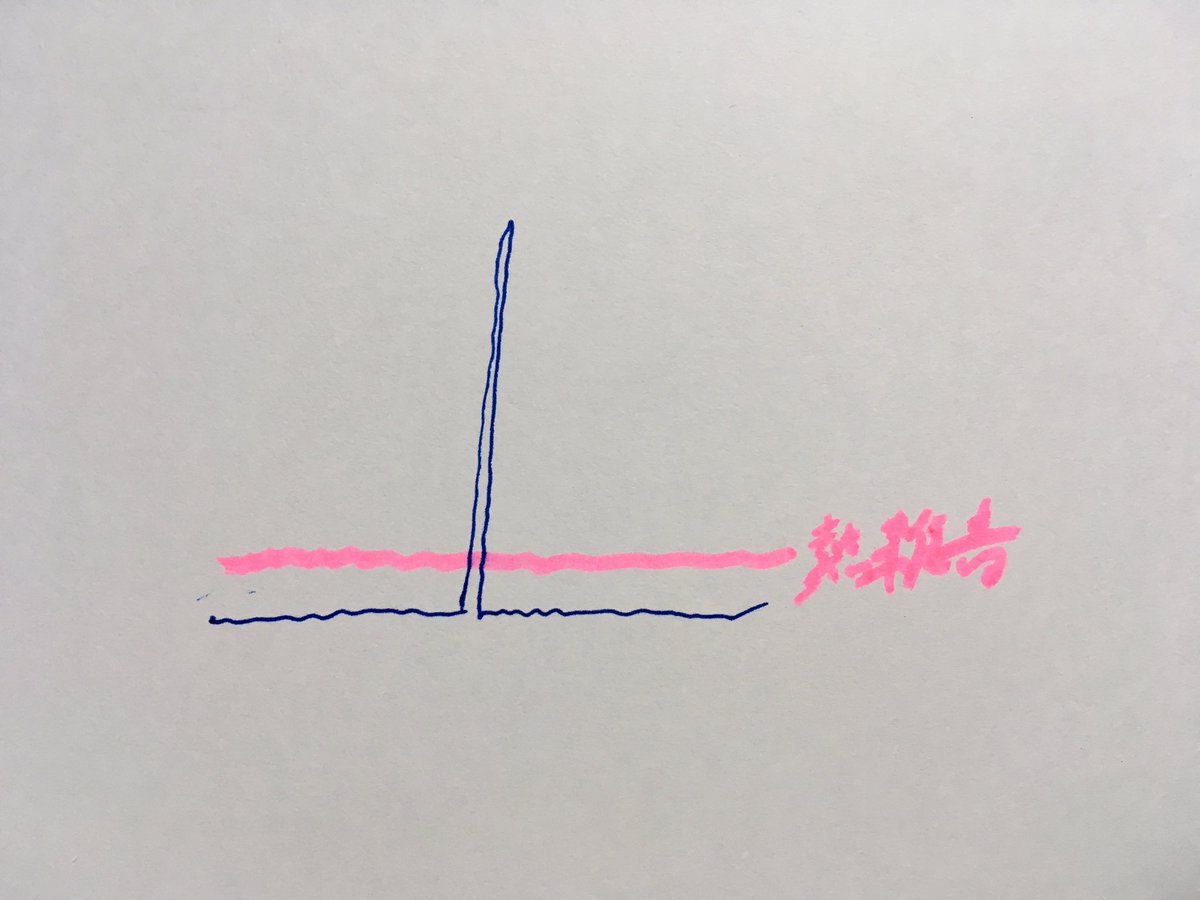

で、ここまでで話題にしているのはあくまでもサンプリング時の量子化誤差(実際の電圧値と近似値間の誤差)により生じるノイズだけです。これが十分に低ければ、たとえばアナログ回路の素子が発するノイズが勝るため、無視できます pic.twitter.com/NRMGOGVp4x

2019-06-15 13:53:31 拡大

拡大

Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

あと、可聴レベル範囲ですね。たとえば人間が聴覚にダメージを受けることなく聴ける最大音量と知覚可能な最小音量の差が120dBとすれば(確かそのぐらいだったと思いますが概算です)、媒体もそれだけのS/Nがあれば十分と考えられます。現実には前述のように再生機器側がこの壁を超えていません

2019-06-15 13:58:46 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

それだけ爆音で鳴らすなら、やはりその範囲内でもビット深度を上げた方が信号精度は上がりそうな印象を受けますが、そこで「実際に変わるのはS/Nだけ」という最初の話に戻るわけです 以上…かな?

2019-06-15 14:00:34 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

逆ですね、カクカクしているのは高い周波数です。 矩形波にハイパスフィルタをかけると、奇数倍音が削られて徐々に丸くなり、同じサイクルでも基音である正弦波に近づくのをイメージしていただけるとわかりやすいかと思います twitter.com/OttomanSlime/s…

2019-06-15 14:07:27 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

@pukumaro スムーズになるのはD/A変換時ですが、ノイズは変換前のデジタルの状態のときから存在します。 PCM収録している時点で、近似値に丸め込まれたすでに各サンプルは元信号(あるいは理想値)との誤差を保持しているわけですので。DAW内で炊いた正弦波がスペアナVSTでノイズフロアを示すのもこのためです

2019-06-15 14:10:13DACには必ずローパスフィルタが入っているのか?というご質問に対して

Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

@ANG_Orchestra 1サンプルごとに上下往復する信号をご想像いただくとわかりやすいかと思いますが、ナイキスト周波数に等しい周波数の「矩形波」は、本来記録し得ない、原音にはないことがわかっている成分です。それを除去するためのローパス処理がD/Aではセオリーと理解しています。

2019-06-15 17:35:53 Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

@ANG_Orchestra そのようになります。ちなみにエイリアスノイズ回避のためA/D変換時も通常はローパスフィルタを通過します(アナログorデジタルオーバーサンプリングのいずれの領域で実施するかについては各手法がありますが) 関心がおありでしたらこちらの本がお役に立つかもしれません amzn.to/31JDT6a

2019-06-15 18:49:19 たけし@ロサンゼルス在住🇺🇸🇯🇵DTMer💻🎼🎸

@takeshiseo

たけし@ロサンゼルス在住🇺🇸🇯🇵DTMer💻🎼🎸

@takeshiseo

同じ音源で24bitと8bitの聴き比べ♫ 「ビット深度によって変わるのはS/Nだけ。解像度は変わらない」 The truth about bit-depth and digital audio resolution youtu.be/Rc_-eavKptY via @YouTube twitter.com/VocalEdit_com/…

2019-06-15 17:04:35# 最後に宣伝です…

Vocal-EDIT.com

@VocalEdit_com

Vocal-EDIT.com

@VocalEdit_com

このスレッドの話題はカバーしませんが、似たアプローチで作業中の最適信号レベルなどを考察する(つまりより実用的な)章などが追加された、こちらをご案内しておきます。 pspunch.com/pd/talkback.ht…

2019-06-15 12:05:29