-

icoxfog417

icoxfog417

- 23157

- 77

- 20

- 49

piqcy

@icoxfog417

piqcy

@icoxfog417

言語モデルのタスクで、CNNでLSTM同等以上の精度を出したという話。畳み込んだ結果をGRUに近い機構で処理し、過去の情報が消失しないようにしている。Google Billion Wordのデータセットでは、LSTMと同等の精度を出す一方計算効率が20倍程度改善された。 twitter.com/Smerity/status…

2017-01-01 13:23:09 Smerity

@Smerity

Smerity

@Smerity

Gated Convolutional Networks beat LSTM on LM (WikiText-103 & One Billion LM for single GPU), faster than CuDNN LSTM arxiv.org/abs/1612.08083 pic.twitter.com/UBplrTjEAv

2016-12-26 15:45:45 piqcy

@icoxfog417

piqcy

@icoxfog417

合成画像で学習できると良いけど独特のクセにより上手くいかない、という点を克服する試み。より「本物らしく」するNN対見破るNNで学習(GAN)。元からかけ離れた「本物化」を防ぐため元画像との差異を利用した正規化などの試みがとられている arxiv.org/pdf/1612.07828…

2017-01-01 12:42:55 piqcy

@icoxfog417

piqcy

@icoxfog417

機械学習の仕組みと応用方法をわかりやすく解説してるMachine Learning is Funの連載第6回目。音声認識についてで、音声をどうデータ化するのか、といったところから丁寧に解説されている。 twitter.com/ageitgey/statu…

2017-01-01 12:13:08 Adam Geitgey

@ageitgey

Adam Geitgey

@ageitgey

New article - Machine Learning is Fun #6: Learn how to do Speech Recognition with Deep Learning! medium.com/@ageitgey/mach…

2016-12-24 09:29:54 piqcy

@icoxfog417

piqcy

@icoxfog417

facebook公式のMemory Networkの実装。言語モデルから対話による学習まで、幅広い実装が公開されている。 twitter.com/soumithchintal…

2017-01-01 12:06:44 Soumith Chintala

@soumithchintala

Soumith Chintala

@soumithchintala

Code & Data for Key-Value Memory Nets and 3 more papers on Dialogue-interaction by #FAIR's Jason Weston et. al.: github.com/facebook/MemNN pic.twitter.com/xcksx1FHsn

2016-12-23 02:08:33 piqcy

@icoxfog417

piqcy

@icoxfog417

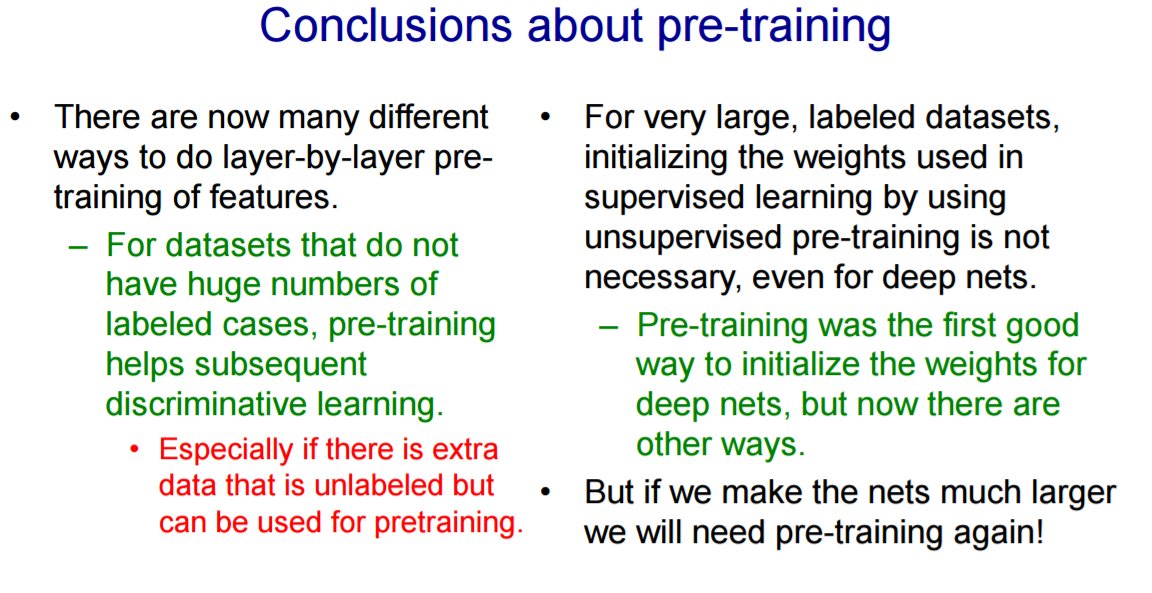

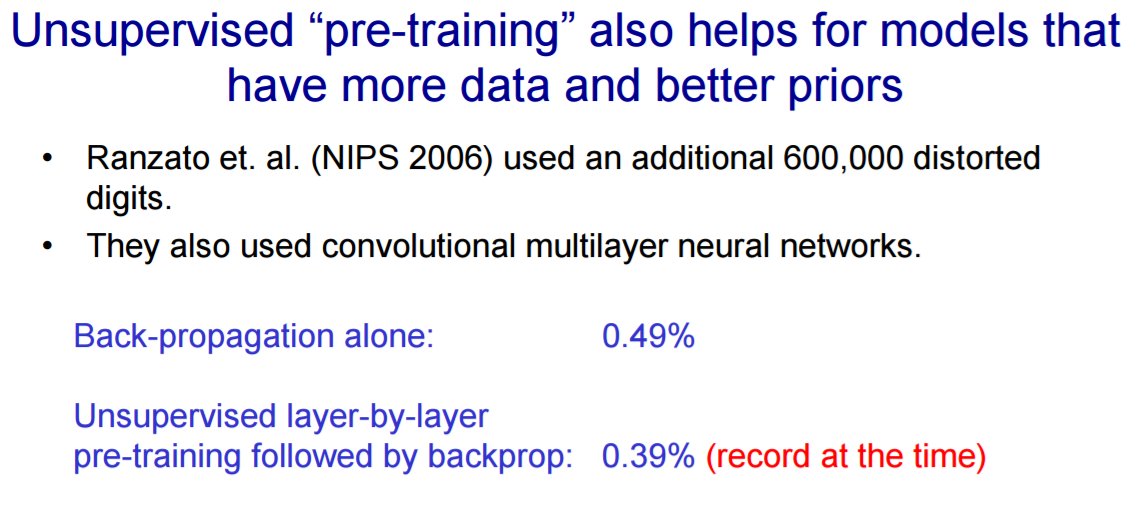

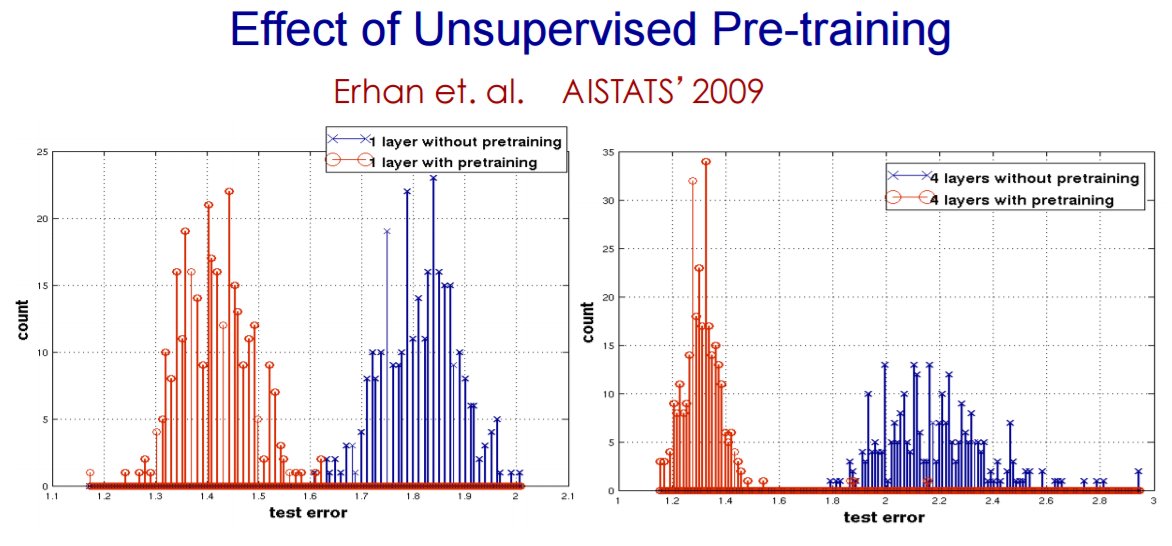

@icoxfog417 ただ、大規模なラベル付きのデータセットではなくても学習できる、と言う話なだけで事前学習そのものの有効性が失われたわけではない。 twitter.com/icoxfog417/sta… ラベル付きのデータがない場合、また深層な場合は初期化方法として有効に使える。 pic.twitter.com/E01VTqdj2K

2017-01-01 09:09:25 piqcy

@icoxfog417

piqcy

@icoxfog417

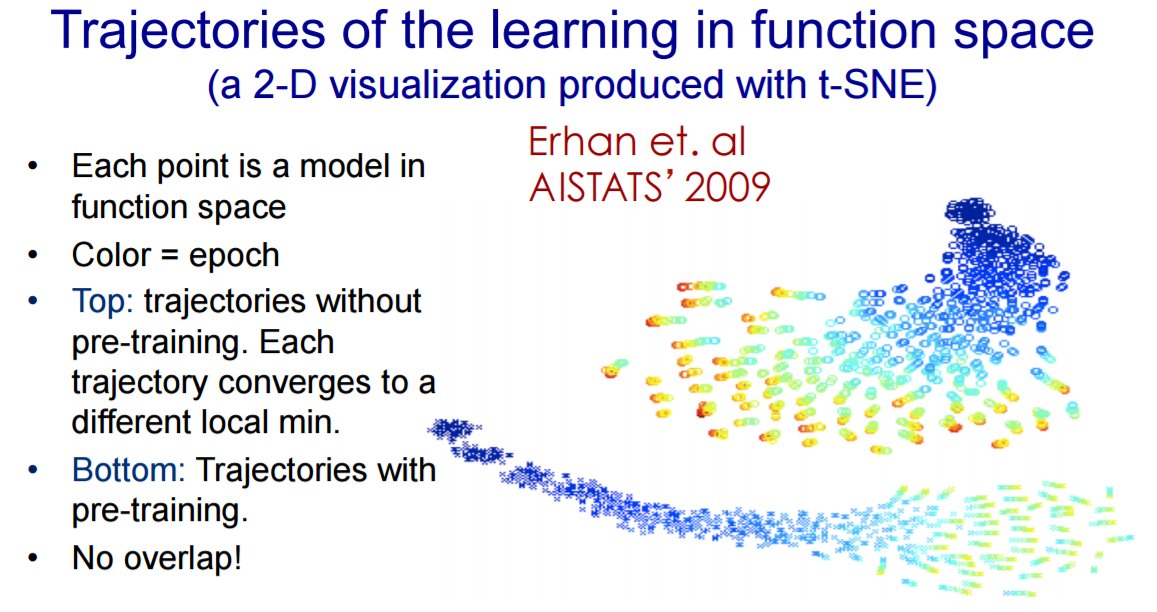

事前学習の有効性を示すデータ(Hinton先生講義)。やらないでもいいがやればより上手くいくということか。3次元の強化学習で教師なしを導入した例もあったので(↓)事前学習というよりは教師なしの特徴抽出の文脈に移行しただけかもしれない github.com/arXivTimes/arX… pic.twitter.com/0TpGn0D0tq

2016-12-29 09:11:44 拡大

拡大

piqcy

@icoxfog417

piqcy

@icoxfog417

2016年最後の仕事、Udemyでアプリケーション開発者向けの機械学習講座を開講しました。 機械学習単体だけでなく、導入プロセスや設計方法など「実際どうするのよ?」という所に答えらえる内容を目指しました。年末年始のお供によろしくです udemy.com/ml_for_app_dev… pic.twitter.com/Z6TtbtYZZf

2016-12-30 11:25:27 拡大

拡大

piqcy

@icoxfog417

piqcy

@icoxfog417

事前学習の有効性を示すデータ(Hinton先生講義)。やらないでもいいがやればより上手くいくということか。3次元の強化学習で教師なしを導入した例もあったので(↓)事前学習というよりは教師なしの特徴抽出の文脈に移行しただけかもしれない github.com/arXivTimes/arX… pic.twitter.com/0TpGn0D0tq

2016-12-29 09:11:44 拡大

拡大

拡大

拡大

拡大

拡大

Shinya Yuki

@shinya_elix

Shinya Yuki

@shinya_elix

強化学習の失敗例。これを報酬に設定すればいいはず、と思ってもagentが思わぬ挙動をしてしまう場合がある。動画が分かりやすい。Faulty Reward Functions in the Wild : openai.com/blog/faulty-re…

2016-12-29 00:09:15 piqcy

@icoxfog417

piqcy

@icoxfog417

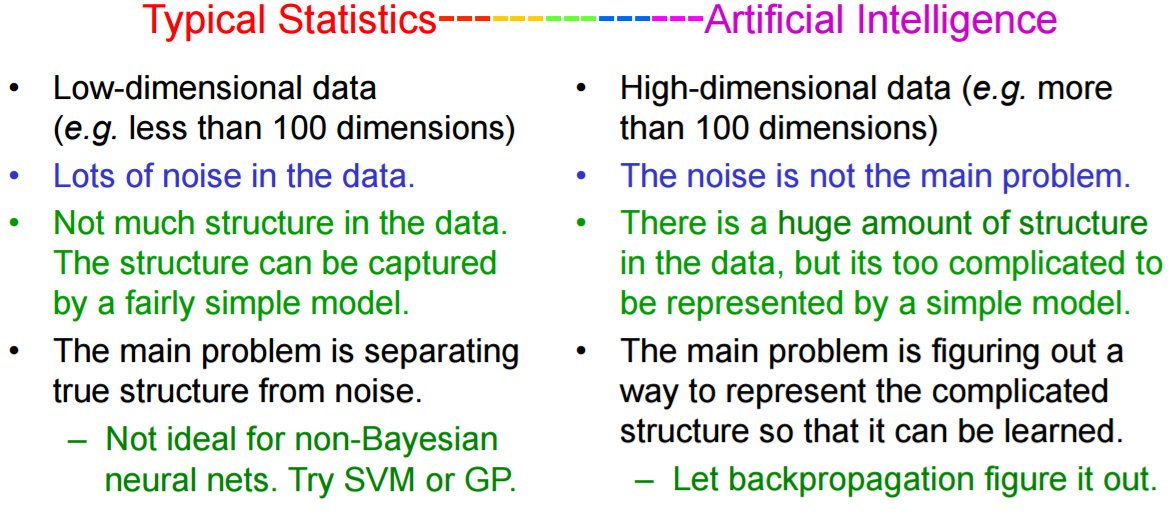

そして統計といわゆる人工知能のタスクの違いについての解説。 統計は低次のノイズが含まれたデータから法則性を見つけ出すこと、人工知能は高次のデータ内に潜む多数の複雑な構造を表現することを目指している、としている。 これは手法の選択を行う際の指針にもなると思う。 pic.twitter.com/zu6A4YISjT

2016-12-28 10:16:27 拡大

拡大

piqcy

@icoxfog417

piqcy

@icoxfog417

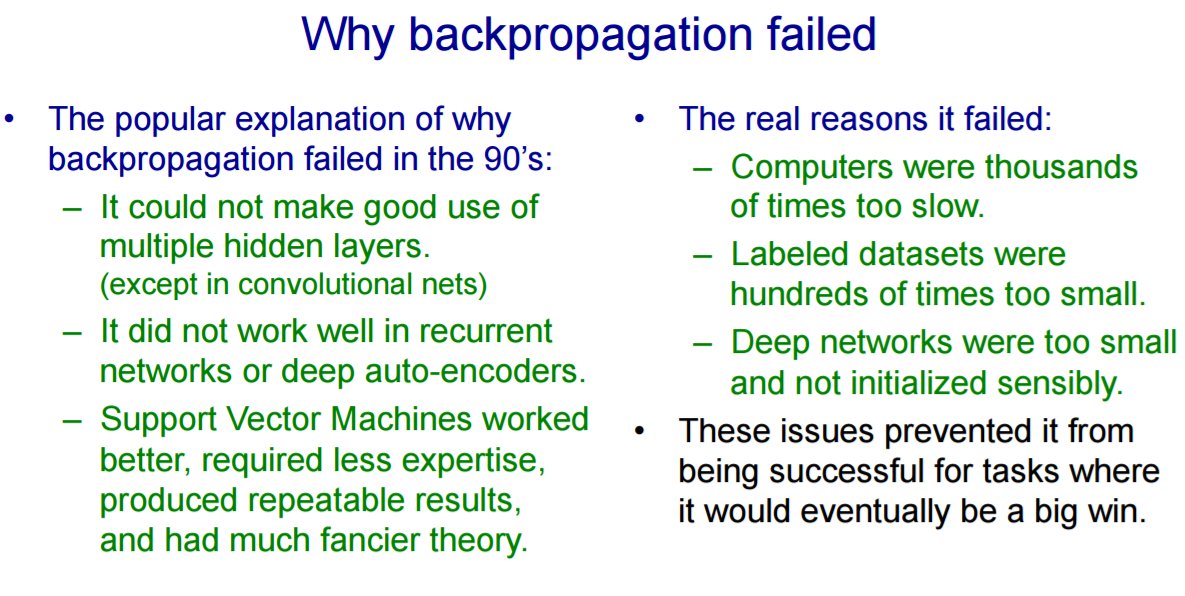

Hinton先生の講義で、なぜBackpropが過去上手くいかなかったのか~と言う話。多層では上手くいかなかった、というのが定説だが計算速度とデータ量、初期化の問題が本当の所だ、という指摘。 実際今では事前学習とか誰もやっていないので、この点が明らかにされてすっきりした感がある。 pic.twitter.com/NVRtBIZ1pY

2016-12-28 09:57:17 拡大

拡大

piqcy

@icoxfog417

piqcy

@icoxfog417

Layer Normalization@NIPS+読み会・関西 #batchnormalization #deeplearning slideshare.net/KeigoNishida/l… @SlideShareさんから

2016-12-28 09:34:12 Shinya Yuki

@shinya_elix

Shinya Yuki

@shinya_elix

非常に読み応えのある大変気合いの入った記事。翻訳を中心としたGoogle Brainが描かれている。メンバーのバックグラウンドだったり、TPUの話なんかも出てきて面白かった。The Great A.I. Awakening: nytimes.com/2016/12/14/mag…

2016-12-28 01:40:23 piqcy

@icoxfog417

piqcy

@icoxfog417

そろそろAdobeあたりからこの辺りのツール(彩色レイヤの自動生成とか)出てくるのではという気がする(実際↓の研究もある)。 github.com/junyanz/iGAN ReDoログをとっていけば、↓みたいに線の生成もできるかも distill.pub/2016/handwriti… twitter.com/tai2an/status/…

2016-12-25 20:15:11 たいざん

@tai2an

たいざん

@tai2an

chainerを使った線画着色についての記事を書きました! qiita.com/taizan/items/c… けっこう自動着色できます。加えてヒントあり着色で塗りたい色を指示することも出来ます。メリークリスマス!#chainer pic.twitter.com/G7EtgWAbDm

2016-12-25 18:17:56 piqcy

@icoxfog417

piqcy

@icoxfog417

SalesForce MetaMindは最近きてると思う。質問応答などの自然言語系で研究を牽引している数少ない部門と思う。 twitter.com/tuntuku_sy/sta…

2016-12-25 19:57:27 Shinya Yuki

@shinya_elix

Shinya Yuki

@shinya_elix

ディープラーニングの研究を行う組織とその傾向のまとめ。“Deep Learning Race: A Survey of Industry Players’ Strategies” by @IntuitMachine medium.com/intuitionmachi…

2016-12-25 14:59:18 piqcy

@icoxfog417

piqcy

@icoxfog417

こうした実運用的な話が出るようになってきて、だんだんとインフラの一部になりつつあると感じる。 Retty流『2200万ユーザを支える機械学習基盤』の作り方 on @Qiita qiita.com/taru0216/items…

2016-12-25 09:38:51 Shinya Yuki

@shinya_elix

Shinya Yuki

@shinya_elix

良いまとめ。Highlights of NIPS 2016: Adversarial Learning, Meta-learning and more blog.aylien.com/highlights-nip…

2016-12-24 14:04:34 piqcy

@icoxfog417

piqcy

@icoxfog417

2年間Kaggleのトップで有り続けたJEREMY HOWARDさんがおくる、数学の知識がなくても学べる実践的なDeep Learningのコース。CNNとRNNをカバーしていて、学習過程でExcelをからめるなど初心者フレンドリーな内容になっているもよう。 twitter.com/antgoldbloom/s…

2016-12-23 13:10:44 Anthony Goldbloom

@antgoldbloom

Anthony Goldbloom

@antgoldbloom

.@jeremyphoward launches a deep learning MOOC for those without a machine learning background course.fast.ai. pic.twitter.com/dGGDlzrInz

2016-12-21 08:46:41 piqcy

@icoxfog417

piqcy

@icoxfog417

BackPropagationは一度手で実装してみること。確かに多くのフレームワークで自動でやってくれるが、その仕組みを理解することは有意義であるし、計算過程でいわゆる「勾配の消失」がなぜ、どのように起こるのか理解できる。それは実装ミスの防止にも役立つ。 という、ありがたい教え twitter.com/karpathy/statu…

2016-12-23 13:06:22 Andrej Karpathy

@karpathy

Andrej Karpathy

@karpathy

A short/quick blog post: “Yes you should understand backprop” medium.com/@karpathy/yes-…

2016-12-20 04:51:50 piqcy

@icoxfog417

piqcy

@icoxfog417

産業/学術団体独立な、ニューラルネットワークを利用した翻訳モデルのオープンソース。実装はTorchベース。ハーバード大が主導している模様。 twitter.com/harvardnlp/sta…

2016-12-23 12:54:04 Sasha Rush

@srush_nlp

Sasha Rush

@srush_nlp

Excited to introduce OpenNMT (opennmt.net), an open-source neural machine translation developed for industrial and academic use. pic.twitter.com/F8nltBkjGO

2016-12-20 02:30:04 piqcy

@icoxfog417

piqcy

@icoxfog417

Encoder-Decoderモデル(with Attention)を使って、文を論理式に変換するという研究(例: 面先が一番大きい県の人口は?⇒(人口: i (argmax _ (県:k _) (面積:i _))))。Lisp的。 arxiv.org/abs/1601.01280

2016-12-23 12:47:13 piqcy

@icoxfog417

piqcy

@icoxfog417

ラベル付けされたデータを作るのはとても大変だから、データのあるソースからデータのあまりないターゲットの画像が作れたらいいよね、という話。ソース⇒ターゲットの画像生成を行うGANを作成し、ドメイン適用を実現。生成画像だけを使った学習で、ほかの手法に対し最高精度を達成。 twitter.com/bousmalis/stat…

2016-12-23 12:32:40 Konstantinos Bousmalis

@bousmalis

Konstantinos Bousmalis

@bousmalis

Our paper on "Unsupervised Pixel-Level Domain Adaptation with GANs" is now on arxiv: arxiv.org/abs/1612.05424

2016-12-19 19:37:50 piqcy

@icoxfog417

piqcy

@icoxfog417

何かのイベント(手を上げたらとか)をトリガに発生する時系列データは、挙動があるタイミングが疎のため既存のLSTMでは学習が難しい(混在するならなおさら)。そこで、時間情報から今ONなのかOFFなのかを制御するPhaseゲートを設けて学習する話。TensorFlow実装有 twitter.com/hardmaru/statu…

2016-12-23 11:32:35 hardmaru

@hardmaru

hardmaru

@hardmaru

Implementation of Phased LSTM in TF (github.com/Enny1991/PLSTM). Code from original author also available (github.com/dannyneil/publ…). twitter.com/hardmaru/statu…

2016-12-19 18:08:21